Autore

Indice

-

L’inconsapevole quotidianità della téchne - CERN: un’esperienza destabilizzante

- Il trionfo di Galileo

- La tecnologia al servizio della conoscenza

- Così l’impasse epistemologica partorì il web (e il Grid)

- Ricadute concrete della fisica teorica

- LHC e il superamento di Babele

- L’errore umano, l’incertezza nella tecnologia, lo Zen nel fare

- L’entusiasmo nella ricerca e gli dei dentro

S&F_n. 09_2013

Abstract

In this paper, some considerations, born directly from the field of the technologist community engaged in the research and development of largest machine built by mankind, the particle accelerator Large Hadron Collider (LHC) at CERN, are presented. By this measuring machine, the technology played a crucial role for science, bringing it to new horizons. Conversely, at CERN, the key concepts of advanced physics have permeated the world of technology. For the technological research, a new cooperative model of public knowledge, free, meritocratic, and supranational, is born. For the technological researcher, a new awareness arises, based on the acceptance of his limits and those of the produced technology. But above all, based on the enthusiasm for a new role of the applied research, no longer dominated by profit, consumption or war, but for finally acting as free knowledge engine.

Nan-in, un maestro giapponese dell'era Meiji (1868-1912), ricevette la visita di un professore universitario che era andato da lui per interrogarlo sullo Zen. Nan-in servì il tè. Colmò la tazza del suo ospite, e poi continuò a versare.

Il professore guardò traboccare il tè, poi non riuscì più a contenersi. «È ricolma. Non ce n'entra più!». «Come questa tazza,» disse Nan-in «tu sei ricolmo delle tue opinioni e congetture. Come posso spiegarti lo Zen, se prima non vuoti la tua tazza?».

N. Senzaki e P. Reps, 101 storie zen

Al di là di ciò che avviene o non avviene, l’attesa è di per sé meravigliosa.

André Breton

- L’inconsapevole quotidianità della téchne

Spesso i ricercatori applicati delle tecnologie di punta confinano il proprio ambito concettuale al mero raggiungimento dell’ottimo tecnico nei suoi vincoli economici e temporali. Si tende a non soffermarsi, per matrice culturale e mentale, sulle implicazioni della propria professione, sottovalutando il proprio ruolo nei mutamenti di sapere, e talvolta ben più drammaticamente, della società e della morale. Si vive beati nel proprio mondo creativo e di superlavoro. Con una notevole dose di duttilità intellettuale si è pronti ad applicare il quantum computing alla diagnostica degli ascensori, la realtà virtuale alle saldatrici industriali, l’intelligenza artificiale alla macchine utensili. Ma il nostro modo di porci domande sulle origini del cosmo, sulla composizione della materia subnucleare, sulla struttura e l’espansione dell’universo, è ancora da liceali, dilettantistico.

Nel frattempo le nuove tecnologie pervadono intensivamente non solo le nostre vite quotidiane, ma anche le frontiere della scienza. Il loro impatto determinante nel modificare il nostro agire abituale e la nostra esistenza è ormai esperienza quotidiana. Tuttavia, forse meno evidente risulta il ruolo cruciale da esse giocato nei progressi della scienza e della nuova visione dell’universo. Questo ruolo della tecnologia e dei suoi operatori non è nuovo nello sviluppo della conoscenza, sin dai tempi della scuola di Mileto e del pensiero ionico. Ma negli ultimi anni sta assumendo un carattere particolare con sfaccettature molteplici. Chi opera in condizioni di responsabilità per la ricerca e sviluppo di nuove tecnologie, non può non porsi interrogativi sul proprio ruolo e sull’impatto dei frutti del proprio agire, abbandonandosi all’inconsapevole quotidianità della téchne.

- CERN: un’esperienza destabilizzante

La stragrande parte dell’ingegneria che si insegna all’università e si pratica nella ricerca applicata è pre-einsteniana. Concettualmente, poi, noi tecnologi in maggioranza siamo rimasti al Circolo di Vienna, neo-positivisti, a Carnap, prima di Heisenberg. Al più abbiamo recepito l’approccio olistico del punto di svolta di Fritjof Capra nei nostri sistemi olonici di monitoraggio. Nella nostra visione del mondo non linearità e incertezza sono problemi da marginalizzare mediante opportune assunzioni nei nostri modelli iper-specialistici.

Esserci integrati con i fisici delle particelle al CERN per progettare e sviluppare il Large Hadron Collider (LHC) è stata un’esperienza non solamente culturalmente inedita, ma soprattutto destabilizzante delle nostre categorie intellettuali. La ricerca che faremo non sarà mai più la stessa, il nostro atteggiamento ne è rimasto cambiato indelebilmente. Abbiamo appreso con stupore che la massa di un protone è generata al 99% da energia di interazione, e solo all’1% dalla massa dei 3 quarks componenti. Abbiamo realizzato che la massa dei quark risulta definita soltanto dinamicamente, cioè la massa dipende dalla scala di energia a cui i quark vengono sondati. Alla scala di energie di LHC, la massa dei quark è sì molto molto piccola rispetto alla massa del protone, ma a quelle scale il protone è schematizzato come più quarks e non solo 3. Tutto ciò ci ha segnato per sempre. Abbiamo realizzato finalmente che l’equazione di Einstein, massa proporzionale a energia, non vale solo nel senso di produrre energia dalla massa (energia nucleare). Ma, ovviamente (solo ora che lo sappiamo), vale anche nell’altro senso, e cioè che l’energia è equivalente a una massa. E quindi che la massa del protone è soprattutto prodotta da energia.

Non solo: abbiamo appreso che il vuoto non è tale, ma impregnato del condensato di Higgs, e che la sua interazione con le particelle dona a esse le proprietà della massa. Ed ancora tanto altro, di materia oscura, antimateria, ecc.

Una cosa è leggere articoli divulgativi o libri per passione, un’altra è ritrovarsi a cena nella mensa del CERN a discutere di questi argomenti con i fisici protagonisti di questi esperimenti. Scherzosamente motteggiare di superiorità intellettuale tra ingegneria e fisica e dell’astrusità della ricerca sulle particelle elementari o della testa dell’ingegnere. Alla fine, dalla diffidenza culturale nasce una stima reciproca: il fisico ti guarda con rispetto per la capacità della tua ricerca di spremere soldi ai falchi dell’industria, e tu invece per la sua abilità di andare all’essenza dei problemi della conoscenza, quelli seri, cosmogonici. E quindi si finisce a scambiarsi punti di vista, informazioni, e si arriva a confrontarsi su come si vedano in modo diverso anche entità rassicuranti e quotidianamente vicine al nostro operare, quali il campo magnetico, la luce, la massa.

E infine, quando si capisce che il massimo obiettivo per noi concepibile a priori, che i nostri strumenti di misura per i magneti siano stati venduti dal CERN a un’industria privata, è trascurabile rispetto al nostro contributo infinitesimo per LHC, e quindi per le misure dell’ Higgs, il gioco è fatto, la nostra weltanschauung è ormai cambiata.

Da questa esperienza culturalmente e intellettualmente complessa, l’ingenuo neo-positivismo del nostro fare ricerca tecnologica rimane scosso, traballante per sempre. Lo iato concettuale tra fisica avanzata e tecnologia di punta si è cominciato a colmare.

- Il trionfo di Galileo

Ma anche il nostro fare tecnologia avanzata ha la sua influenza sulla fisica di punta. Per comprendere ciò basta una semplice riflessione. Esperimenti fondamentali per l’avanzamento delle frontiere della scienza nel secolo scorso, quali ad esempio quello di Michelson-Morley che portò alla scoperta della non esistenza dell’etere, sono stati realizzati con l’uso di tecnologie relativamente semplici in proporzione al sapere contemporaneo. O perlomeno alla portata di un singolo laboratorio. Viceversa, negli anni recenti, l’acceleratore di particelle LHC che ha portato alla misura del bosone di Higgs, e che sta aprendo le frontiere della nuova fisica, è un eccezionale sforzo sovranazionale di innovazione tecnologica e di ricerca di ingegneria.

LHC con i suoi esperimenti è frutto di uno sforzo corale di centinaia di laboratori nel mondo, e di molteplici tecnologie che non sono solo del CERN. A essere precisi, il CERN ha costituito il luogo e l’occasione per catalizzare una vasta comunità sovranazionale di ricercatori di ingegneria e di fisica sperimentale, che ha trovato in questo ambizioso progetto il proprio scopo scientifico per più di un decennio. Il primo risultato è stato che LHC è la macchina più grande mai costruita dal genere umano. Il secondo aspetto non meno importante è che tale macchina sia uno strumento di misura. Ciò rappresenta la massima espressione del pensiero sperimentale Galileiano: la più grande messe di scoperte scientifiche di questo momento della nostra civiltà viene realizzata con LHC, che non solo è la più grande macchina costruita dal genere umano, ma che è soprattutto uno strumento di misura.

Non solo, un ulteriore aspetto importante è relativo alla precisione della misurazione come indice dello sviluppo di una civiltà. Secondo Galileo noi conosciamo solo ciò che misuriamo. LHC è uno strumento di misura multifunzione di precisione insuperata in molti suoi componenti cruciali. LHC ci ha portato alle frontiere della fisica per cui oggi si parla addirittura di una nuova fisica dopo l’Higgs. Ecco quindi, nel nostro approccio galileiano: alle frontiere della tecnologia, gli orizzonti della nuova fisica.

Questa congiuntura non è nuova nella storia della scienza. Tuttavia, per LHC ha assunto delle peculiarità che devono far riflettere non solo i metrologi, i tecnologi e i fisici, ma tutti quanti.

- La tecnologia al servizio della conoscenza

Aggiungo a tal proposito alcuni spunti personali di riflessione: la macchina più grande costruita dall’uomo non è uno strumento di guerra, né di profitto economico, ma di conoscenza.

Non solo: tale strumento poderoso di conoscenza non è mirato alla ricerca applicata, ma di base. Cioè è finalizzato non a scopi materiali, ma meramente culturali. LHC è cioè una macchina finalizzata ad accrescere il sapere umano, riformulando concetti di base quali la struttura della materia, la massa, e la composizione dell’universo.

E va ulteriormente sottolineato a chi vuole ridurre la ricerca tecnologica a mera innovazione di prodotto guidata dal mercato e dal privato: la nuova frontiera tecnologica di LHC non è alla portata di un privato (come già sottolineato, e nemmeno di una nazione) guidato dal calcolo del rischio e del profitto. Neppure i più visionari o più ricchi del pianeta.

Ancora: questa macchina nasce da un’armoniosa cooperazione integrata, con carattere fortemente sovranazionale. Non si tratta di una affermazione astratta: ad esempio, nella composizione dei turni di lavoro nei test di serie dei magneti, è stato necessario porre attenzione alla lingua dei tecnici per permettere la comunicazione ed evitare la babele. Inoltre, hanno cooperato ricercatori e tecnici di provenienza sia scientifica sia tecnologica. Si è trattato di una vasta cooperazione trasversale che ha implicato l’integrazione delle tecnologie più disparate: software, hardware, di strumentazione, controlli, elaborazione del segnale, ingegneria civile, meccanica e tante altre. Persino manageriali. Con una forte sintesi, si può dire che lo sviluppo di gran parte dei sistemi tecnologici portanti dell’acceleratore è stato gestito secondo un approccio “centralizzato”, classico dell’ingegneria delle grandi opere: i vari gruppi lavoravano secondo un piano predeterminato spinto e tempificato dall’alto. Al contrario, gli esperimenti di LHC sono stati realizzati con una gestione “distribuita” innovativa per l’ingegneria, ma non per la fisica: ciascun laboratorio gestisce autonomamente il proprio obiettivo, che viene poi coordinato nel quadro globale, ma senza un piano capillare imposto dall’alto.

Lo sforzo tecnologico di LHC è dunque frutto di una cooperazione pacifica di esperti sperimentatori nel segno della conoscenza, che ha sfruttato (e portato) al massimo livello attuale le capacità tecnologiche del genere umano. Insomma, per una volta tanto, invece che del profitto, del conflitto, del consumo, la tecnologia è al servizio della conoscenza.

- Così l’impasse epistemologica partorì il web (e il Grid)

Una delle maggiori sfide epistemologiche che ha posto questa peculiare centralità della tecnologia nella fisica è stata la non riproducibilità dell’esperimento con una macchina così grande da essere unica. Uno dei cardini dell’approccio scientifico galileiano statuisce che l’esperimento per divenire scienza deve essere poter essere riprodotto in differenti laboratori, con diversi strumenti, da chiunque. In altri termini, chiunque deve poter ottenere gli stessi risultati. Viceversa, i grandi acceleratori di particelle come LHC sono macchine uniche al mondo, e quindi i risultati dei loro esperimenti non sono ottenibili in qualunque laboratorio[1]. Dunque, il web e internet nascono al CERN proprio da questo impasse epistemologico come tecnologie informatiche per mettere a disposizione i risultati sperimentali in tempo reale all’intera comunità scientifica. Il web rende accessibili i risultati “grezzi” di misura dell’esperimento (più precisamente quelli dopo una prima pre-elaborazione, detti post-trigger), così che la sua parte finale di analisi possa essere eseguita da chiunque. In tal modo, almeno a valle della lettura dei dati, l’esperimento diviene riproducibile. Il linguaggio HTML di formattazione delle pagine web diviene subito il primo linguaggio universale di informazione. La chimera del linguaggio universale diviene dunque realtà in un ambito che non è quello tipico della speculazione filosofica, ma sul campo delle nuove tecnologie e del loro impatto sul sociale. Quindi ancora dal CERN nasce questo prodromo della terza rivoluzione della Computer Science: dopo la prima rivoluzione hardware degli anni ‘70 dei microprocessori, e la seconda degli anni 80 in cui l’enfasi si sposta sul software, adesso l’accento è posto mediante il networking sull’applicazione alle scienze sociali, economia, sociologia e psicologia. E in particolare alle trasformazioni antropologiche di civiltà, società e costumi imposte dal social networking e dalle corrispondenti apps in ambiente smart mobile.

Il passo dalla condivisione delle informazioni del web alla condivisione della memoria (il cloud) e della potenza di elaborazione (il Grid) è breve. La mostruosa mole di dati ottenuta con gli esperimenti di LHC è stata stimata in un petabyte all’anno, ovvero in un milione di gigabyte all’anno. Quindi, i dati sono disponibili a tutti, ma non elaborabili, servirebbe una potenza di calcolo di costi inaccessibili.

Nasce LHC Computing Grid, il supercomputer “democratico”, una tecnologia per utilizzare le risorse dei sistemi informatici di molti centri di ricerca in similitudine alla rete elettrica. Su scala planetaria l’hardware e il software residenti su varie macchine in più località sono messi a disposizione per l’elaborazione simultanea di grandi quantità di dati. Il superprocesso di elaborazione necessario alla mole di dati sperimentali di LHC viene spezzettato nelle sedi delle componenti di Grid mediante codici messi in comune. Infine, i dati elaborati vengono reintegrati al CERN per l’analisi finale degli eventi. I vari passaggi sfruttano la cooperazione tra vari centri di ricerca, e quindi la ridondanza in modo da minimizzare errori e incertezza. Quindi, un’altra chimera della Computer Science, relativa al Supercalcolatore come antagonista/partner privilegiato di conoscenza del genere umano, non si realizza in uno scenario di predominio tecnologico privato, in un’azienda oligarchica multinazionale. Viceversa, nasce quasi inconsapevolmente in una comunità scientifica, tesa solo alla ricerca di base, per una conoscenza scientifica che si fa cosmogonia e con fortissimi addentellati tipici della discussione filosofica dei massimi sistemi.

Si può azzardare che, alla spinta di parcellizzazione della discussione filosofica novecentesca verso le nuove scienze sociali, facciano da contraltare centralizzante e unificante le tecnologie di networking del sapere e la riflessione sui grandi temi che scaturisce dagli orizzonti della nuova fisica.

- Ricadute concrete della fisica teorica

Infatti, questo modello di cooperazione di LHC contribuisce a sviluppare tecnologie che generano nuovi meccanismi di diffusione della conoscenza scientifica. arXiv (che non è tecnologia CERN) è un nuovo sistema di raccolta dei manoscritti scientifici per anticipare nuovi risultati prima della pubblicazione (preprint). I tempi lunghi di pubblicazione (dai 2 mesi ai 2 anni) delle riviste rispetto a quelli del febbrile sviluppo tecnologico attuale ne hanno determinato una diffusione travolgente. Il sito arXiv è libero, tutti posso accedere e scaricare i manoscritti in vari formati digitali e leggere le novità da tutto il mondo. Quindi, grazie ad arXiv, anche il sapere più specialistico è messo in comune immediatamente, gratuitamente, e veramente alla portata di tutti, prima che i gruppi editoriali scientifici ne rivendichino i diritti. Su questa onda, sempre più riviste scientifiche anche prestigiose, oltre a essere on line, divengono in maggioranza open access, cioè molti articoli diventano accessibili gratuitamente. In tal modo, vengono rivoluzionati ulteriormente i meccanismi di diffusione della ricerca nella direzione di una svalutazione del sapere di elite e di una conoscenza scientifica e tecnologica che si fa sempre più cooperativa e pervasiva. Ai meccanismi auto-referenziali e cooptativi di una accademia italiana che non sa decifrare la recente entità della emigrazione dei cervelli, si contrappone un modello cooperativo di sapere scientifico e tecnologico, libero, sovranazionale, meritocratico, che pone creatività e riscontro fattuale al centro del proprio orizzonte metodologico. E tale modello trova al CERN in LHC un prototipo realizzativo di inedita risonanza.

Ciò senza contare risultati di LHC forse meno eclatanti a livello metodologico, ma ben più importanti per il diretto impatto sulla società civile. Ad esempio, per la cura del cancro. Con la stessa tecnologia di LHC, ma su dimensioni ridotte, la adroterapia consente di distruggere un tumore ben definito, sito in profondità nel tessuto umano, senza operare chirurgicamente il paziente. Oppure l’impiego dell'antimateria per la diagnostica medica, con la tomografia a emissione di positroni, (o PET, dall'inglese Positron Emission Tomography), che fornisce mappe dei processi funzionali all'interno del corpo, e non solo informazioni di tipo morfologico come le altre tecniche tradizionali.

O per il problema energetico: una delle tecnologie portanti di LHC, quella dei magneti superconduttori, viene trasferita a ITER, un progetto internazionale che si propone di realizzare un reattore sperimentale a fusione nucleare in grado di produrre più energia di quanta ne consumi per l'innesco e il sostentamento della reazione di fusione. Principale frutto di ITER sarà DEMO, il futuro prototipo di centrale elettrica a fusione, con vantaggi stimati notevoli: reazioni di fusione alimentate da deuterio, abbondante negli oceani, nessun trasporto di materiale contaminante, nessun problema di sicurezza poiché il reattore fuori controllo si spegne immediatamente, nessuna utilità a fini bellici, e, soprattutto, produzione di energia senza gas serra.

Quindi, la commistione tecnologia-scienza non dà frutti puramente concettuali e metodologici per la conoscenza, ma incide fattivamente sulla società, secondo i paradigmi tipici di una società che si fa sempre più tecnologica. Insomma, sapere e tecnologia avanzata per la società diventano sempre più facce della stessa medaglia.

- LHC e il superamento di Babele

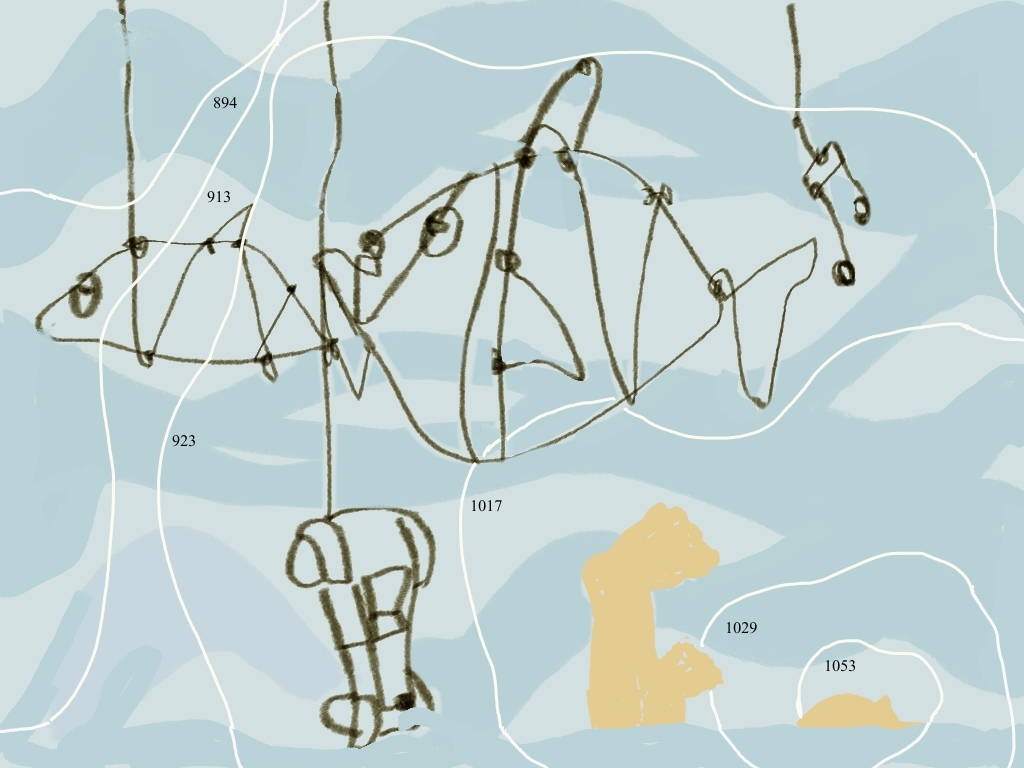

La complessità strutturale e tecnologica di LHC è veramente notevole. I record della macchina sono ormai arcinoti nella vulgata della rete. In una stessa macchina sono concentrati: un livello di vuoto pari a un decimo di quello sulla superficie della luna, il secondo luogo più freddo dell’universo massivo[2] (inferiore di 0.7 gradi alla temperatura media dell’universo), un campo magnetico di circa 80000 volte quello terrestre, una lunghezza dei filamenti dei cavi superconduttori pari all’orbita della terra attorno al sole, una produzione di dati durante ogni esperimento notevolmente superiore a quello dell’intero pianeta nello stesso tempo. Le due cattedrali dense di elettronica dei due principali esperimenti di LHC, ATLAS e CMS, sono state allineate alle aperture dei magneti per il transito del fascio al milionesimo di metro. E il tutto con un costo pari alla metà del totale degli ingaggi dei calciatori italiani durante gli anni della sua costruzione.

È facile oggi per i leader della progettazione e dello sviluppo affermare che un risultato positivo di LHC era scontato grazie alla bravura del Team (e della sua leadership) e alla qualità del progetto. In realtà, è noto a tutti gli operatori al CERN che c’è stato un momento, culminato con l’incidente del 2008, in cui è serpeggiato nella comunità dei tecnologi un “complesso di Babele”. Si è cioè temuto che una macchina così complessa e con calcoli di affidabilità estremamente complicati potesse non funzionare in modo stabile e duraturo. Questo complesso, a valle dell’incidente è stato superato con la serena operosità del positive thinking peculiare dei tecnologi e degli sperimentatori. Parafrasando Lucio Rossi, attuale responsabile del progetto “LHC upgrade”, all’atto dell’incidente, al di là della corsa allo scarico della responsabilità, si è affermata invece una chiara coscienza che per uno sviluppo tecnologico di tali dimensioni è necessario e fruttuoso accettare i limiti intrinseci di una tecnologia.

Concludendo con Lucio Rossi: «Se tale incertezza, quindi il nostro limite, viene messo in conto come parte ineliminabile del nostro agire, allora le nostre energie sono libere per la costruzione, e questo rende meno sospettosi gli uni verso gli altri nella corsa a “smarcarsi” dalla colpa. Tutto ciò permette quindi una dinamica di comune intento che veramente moltiplica le forze».

- L’errore umano, l’incertezza nella tecnologia, lo Zen nel fare

L’accettazione dei limiti della tecnologia è necessaria perché la previsione e la gestione proattiva dell’errore ne consentono la limitazione degli effetti. In termini di una maggiore consapevolezza della tecnologia, in uno dei momenti della massima espressione dell’agire umano quale è stato lo sforzo corale di LHC, ciò implica l’accettazione preventiva dell’ineludibilità dell’errare. Anzi, l’errore è motore di conoscenza e di progresso tecnologico.

D’altronde, questo è un concetto ben noto a noi sperimentali, fisici e ingegneri: un’aliquota determinabile di incertezza deve essere messa in conto come parte ineludibile dello sviluppo tecnologico, proprio come l’errore lo è nell’agire umano. Anzi, noi metrologi chiamiamo precisione proprio la capacità di esprimere quantitativamente l’incertezza. Possiamo parlare di precisione solo se siamo in grado di dominare l’incertezza, accettandola come ineludibile, e portandola in conto nei nostri calcoli, nelle nostre realizzazioni tecnologiche. Il risultato dell’innovazione tecnologica si concretizza spesso proprio in una diminuzione dell’incertezza, nel poter aumentare le cifre significative di un risultato sperimentale, nel conoscere meglio il valore di una grandezza fisica. Molto spesso questo traguardo frutta il dominio di un mercato a un’azienda, consente ai magneti di LHC di portare la qualità della collisione dei fasci per la produzione delle particelle di Higgs a un livello tale da renderne significativa la misura. Questi sono solo due esempi di come l’affermazione apparentemente astratta che la riduzione dell’incertezza è innovazione tecnologica si articoli nella realtà della nostra professione, nella inconsapevole quotidianità della téchne.

Questo atteggiamento di intrinseca accettazione dell’errare è anche fruttuoso, in quanto l’errore innesca un ciclo virtuoso di correzione. Questo è il principio portante dell’inseguimento di un riferimento (tracking) nella retroazione, in ingegneria dell’automazione e in cibernetica. Mediante tale meccanismo di cancellazione degli errori rispetto alle condizioni ideali di sopravvivenza, un sistema che interagisce con l'ambiente si mantiene in uno stato stabile, modificando opportunamente il proprio comportamento in risposta alle variazioni ambientali. Gli organismi viventi sfruttano la percezione dell’errore per la sua correzione per sopravvivere. Ad esempio, reagendo alle deviazioni di temperatura, i mammiferi mantengono la temperatura corporea costante. Infatti, le condizioni interne di un essere vivente devono rimanere entro valori molto ristretti poiché una variazione eccessiva è incompatibile con la vita. Le sollecitazioni dell'ambiente sono controbilanciate da adattamenti interni compensativi. Dunque la percezione della non idealità è alla base della sopravvivenza nostra e delle forme di vita.

Questo è anche uno dei principi di base dell’arte Zen: a differenza delle espressioni artistiche della classicità, dove la simmetria rappresenta la ricerca della perfezione, e della sua trasposizione etica dell’areté, lo Zen insegna che la perfezione, in quanto antitetica con l’esistenza umana, è essa stessa un ostacolo al raggiungimento della consapevolezza suprema, e pertanto va evitata. L’imperfezione è insita in qualsiasi opera Zen, in un componimento haiku, nell’architettura di un giardino, o nelle pratiche marziali giapponesi. Ad esempio, nell’aikido, è proprio la percezione dello sbilanciamento insito nell’attacco e il suo sapiente sfruttamento per la difesa che portano a un ristabilimento dell’equilibrio: l’aggredito riporta la vittoria non violenta tramite un “massaggio” sulle giunture dell’aggressore (portato oltre il limite del dolore, ma ben prima del danno strutturale).

L’errore, la sua determinazione quantitativa e il successivo processo di correzione sono alla base della trasposizione dell’arte Zen nell’ingegneria di processo con il concetto di kaizen nella qualità della produzione. Nel kaizen, l’errore non solo è previsto, ma è addirittura necessario come innesco e motore del continuo processo di miglioramento tecnologico. I limiti della tecnologia sono continuamente esplorati per superarli e produrre un miglioramento continuo delle prestazioni. D’altronde, siamo all’essenza dell’operare della ricerca, ben nota a tutti noi: è dall’analisi dei limiti dello stato dell’arte che nascono le nuove idee e dunque la ricerca. Senza la presa di coscienza degli errori e dei limiti dello stato dell’arte, la ricerca non è tale, non vi è innovazione, si rischia di re-inventare il fiammifero.

- L’entusiasmo nella ricerca e gli dei dentro

Per concludere, sul campo di LHC, tutti noi operatori abbiamo sperimentato e appreso una cosa che tuttavia non è stata evidenziata a sufficienza, sebbene sia stata frutto di un sentire comune a tutti al CERN, dai fisici agli ingegneri, dal management alle maestranze. Ciò che veramente ha moltiplicato gli effetti, al di là dell’accettazione dell’errore, è stato l’entusiasmo. Tutto lo sviluppo di LHC è stato pervaso da un enorme e tangibile entusiasmo. E forse proprio il contagio di questo entusiasmo è stata l’esperienza più importante dei miei 8 ultimi anni di CERN. Non solo l’entusiasmo delle occasioni ufficiali, come in sala di controllo quando il primo fascio di particelle è circolato e la macchina ha iniziato a funzionare. E non solo quando LHC a metà energia e a una bassa frazione di “luminosità” nominale ha dato la significatività necessaria alla misura dell’Higgs. Ma quello del quotidiano, delle piccole cose, continuo, interiore, che nasceva dal sentirsi parte infinitesima, ma determinante, di una grande impresa. L’entusiasmo, unito alla precisione naturale e raffinata delle movenze da artisti Zen, con cui le maestranze CERN in caverna allineavano al millesimo di millimetro, a passi intercalati di martinetto e spessori di metallo, i giganteschi esperimenti con i magneti dell’anello di LHC, seguendo i sistemi di posizionamento al laser. Dei giovani dottorandi e post-doc nel ripetere i calcoli e le simulazioni infinitamente, di giorno come di notte, in settimana e nel week end. Dei responsabili meno giovani, nel buttarsi in sfide tecniche impensabili qualche mese prima, con semplicità, ordine e disciplina. E dei tecnici, nel ripetere i test ancora, e ancora e ancora una volta, per essere veramente sicuri di risultati che vedevamo per la prima volta, perché poi dovevano funzionare per anni.

Tutto ciò ha reso lo sviluppo di LHC e dei suoi esperimenti un’esperienza professionale e scientifica unica, di cui fare tesoro tutti, e non solo per la ricerca.

Ma già emergono nuove frontiere per la ricerca applicata, nuove sfide a cui rivolgerci con rinnovata creatività: per l’upgrade di LHC, per gli esperimenti, che sono stati concepiti 20 anni fa e oggi sarebbero progettati in maniera molto diversa, risulterebbero molto più performanti. Altre macchine sono poi in via di progettazione in Giappone, Cina e altrove. LHC è stato soltanto l'inizio. Ci ha indicato un cammino, ma è un dito che indica la luna, non la luna stessa. Il momento è bello, ma forse più per il futuro che ci aspetta, che per i risultati ottenuti con LHC.

Concludendo, a parte il resto meramente tecnico, sono molteplici i fattori chiave, quali cooperazione internazionale pacifica, integrazione scientifica e tecnologica, gestione della limitatezza, ed entusiasmo per la ricerca, che hanno portato in modo peculiare per LHC, alle frontiere della tecnologia, gli orizzonti della nuova fisica. Però, entusiasmo deriva dal greco antico, e significa avere gli dei dentro.

[1] Anche per questo LHC ha due esperimenti principali e totalmente indipendenti: ATLAS e CMS.

[2] Il luogo più freddo dell’universo massivo noto è Boomerang Nebula – una stella gigante che genera una nebula planetaria, 5000 anni luce dalla Terra.